A transmissão de vídeo sobre redes de dados tornou-se elemento estratégico em ambientes corporativos, aplicações residenciais e especialmente em sistemas críticos de segurança eletrônica, onde a integridade e o tempo de entrega das imagens são fatores determinantes para a eficiência do monitoramento e das respostas operacionais. Entretanto, desafios relacionados à latência, à variabilidade do atraso […]

Confira!

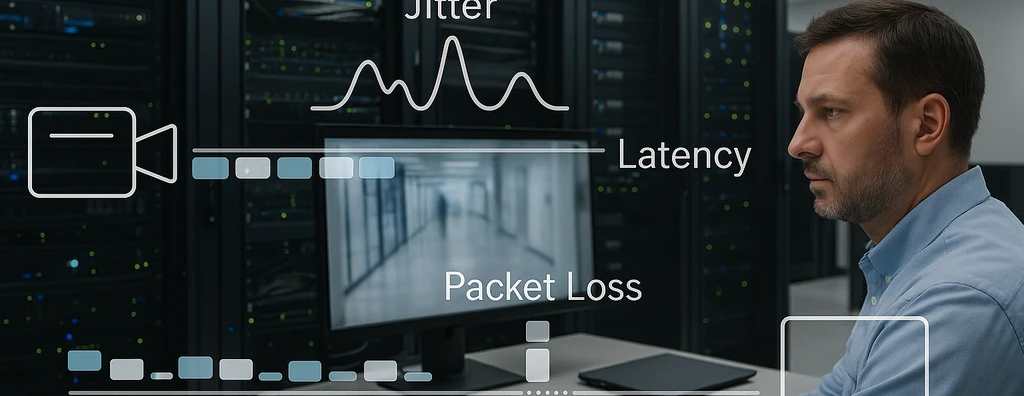

A transmissão de vídeo sobre redes de dados tornou-se elemento estratégico em ambientes corporativos, aplicações residenciais e especialmente em sistemas críticos de segurança eletrônica, onde a integridade e o tempo de entrega das imagens são fatores determinantes para a eficiência do monitoramento e das respostas operacionais. Entretanto, desafios relacionados à latência, à variabilidade do atraso (jitter) e à perda de pacotes afetam diretamente a experiência final, podendo comprometer desde a visibilidade em tempo real até a gravação fidedigna dos eventos. A compreensão técnica desses parâmetros é fundamental para a engenharia de redes que busca alto desempenho, disponibilidade e qualidade de serviço.

Neste artigo, são examinados os conceitos de latência, jitter e perda de pacotes, suas relações de causa e efeito na transmissão de vídeo, os mecanismos para mitigação dos impactos e suas implicações práticas em projetos, operação e dimensionamento de redes destinadas a tráfego de vídeo. O objetivo é fornecer subsídios técnicos para decisões críticas em engenharia, arquitetura e operação de sistemas de transmissão audiovisual.

Confira!

[elementor-template id=”24446″]

Latência: Conceito, Origens e Efeitos na Transmissão de Vídeo

Latência é definida como o tempo total transcorrido entre o envio de um pacote de dados pela fonte e sua recepção no destino. Esse parâmetro engloba diversos componentes, incluindo o processamento nos equipamentos de rede, tempo de propagação física do sinal, enfileiramento em filas de buffers e tratamento de protocolos em cada nó de passagem.

Na transmissão de vídeo, latências elevadas podem gerar atraso perceptível excessivo entre o evento monitorado e sua apresentação ao usuário, dificultando a interação em aplicações sensíveis ao tempo, como videoconferência e videomonitoramento ao vivo. É importante distinguir:

- Latência de Propagação: Tempo físico demandado para o sinal percorrer o meio físico;

- Latência de Processamento: Tempo consumido nos nós de roteamento/switching devido ao tratamento de pacotes;

- Latência de Enfileiramento: Atraso causado por congestionamento em filas de buffers de switches e roteadores;

- Latência Aplicacional: Tempo de processamento e buffering nos dispositivos finais, incluindo compressão e descompressão de vídeo.

Valores elevados, mesmo que constantes, limitam agilidade e viabilidade de determinados serviços de vídeo.

Jitter: Variação do Atraso e Suas Consequências

Jitter é a expressão técnica para a variação do tempo de chegada dos pacotes no destinatário em relação ao intervalo temporal originalmente previsto. Em redes de dados, sobretudo baseadas em pacotes IP, a presença de jitter é derivada das condições dinâmicas de roteamento, congestionamento momentâneo, balanceamento de rotas e priorização diferenciada de fluxos.

Os impactos do jitter na transmissão de vídeo incluem:

- Ruptura de continuidade na apresentação de quadros (frames);

- Pausas perceptíveis ou saltos na reprodução das imagens;

- Descompasso entre áudio e vídeo em transmissões multimídia sincronizadas;

- Necessidade de implementação de buffers de compensação maiores, aumentando a latência total do sistema.

Aplicações interativas e de monitoramento em tempo real requerem valores minimizados de jitter, pois altas oscilações inviabilizam o uso eficaz dos sistemas, gerando experiências degradadas e riscos operacionais.

Perda de Pacotes: Efeitos Diretos sobre Qualidade Visual e Confiabilidade

Perda de pacotes refere-se à inexistência de entrega de determinados pacotes enviados entre origem e destino, por descarte em nós congestionados, erros de transmissão ou falhas no processamento dos equipamentos intermediários.

No contexto da transmissão de vídeo, a perda pode acarretar:

- Quadros (frames) parcial ou totalmente ausentes na sequência reproduzida;

- Fragmentação ou distorção visual, perceptíveis em eventos de maior duração ou frequência;

- Saltos súbitos de cena, comprometedores para análise forense e acompanhamento em tempo real;

- Em protocolos que dispensam retransmissão em favor de menor latência, a ausência de pacotes tende a ser mascarada com técnicas como repetição de quadros anteriores, inserção de quadros em branco ou ambientação sonora de preenchimento.

Sistemas críticos e aplicações de alta sensibilidade, como segurança perimetral e videomonitoramento de ambientes estratégicos, devem prever taxas máximas de perda tolerável, dimensionando arquitetura e mecanismos de qualidade de serviço apropriados.

Relações entre Latência, Jitter e Perda de Pacotes

Os três parâmetros estão interligados por sua dependência em fatores como taxa de ocupação de banda, design de roteamento, sobrecarga de buffers e eficiência dos algoritmos de priorização (QoS). A mitigação de jitter exige aumento do tamanho dos buffers, colaborando, por vezes, para crescimento da latência total. Por outro lado, buffers muito pequenos podem causar descarte de pacotes sob congestionamento, elevando a taxa de perda.

O dimensionamento do ponto de reprodução no cliente depende do balanceamento entre:

- Latência aceitável: definida pelo máximo atraso tolerável sem comprometer a utilidade do vídeo em tempo real;

- Acomodação do jitter: via buffers suficientemente grandes para absorver variações sem interrupções perceptíveis;

- Risco de perda: calculado a partir da capacidade da rede de entregar pacotes em tempo adequado antes do seu descarte ou substituição.

Essa interdependência requer cálculos criteriosos e monitoramento contínuo, sobretudo em topologias críticas.

Mecanismos e Estratégias de Mitigação

A manutenção da qualidade de transmissão de vídeo exige implantação de técnicas específicas ao longo da infraestrutura de rede e nos endpoints:

- Buffers de Jitter: Implementação de áreas temporárias nos terminais receptores para acomodar a chegada irregular de pacotes, liberando-os para processamento em fluxos contínuos. O dimensionamento do buffer é diretamente proporcional à variação esperada do atraso, tornando-se maior conforme aumenta o jitter tolerável.

- Mecanismos de Qualidade de Serviço (QoS): Classificação, priorização e reserva de banda para fluxos de vídeo sensíveis, reduzindo riscos de congestionamento e perda de pacotes. Tecnologias como filas com prioridades e marcação de pacotes são fundamentais.

- Monitoramento e Ajuste Dinâmico: Análise constante dos parâmetros operacionais de rede, lógica adaptativa para ajuste do playback point, seleção inteligente de rotas e algoritmos de compressão adequados à variabilidade dos indicadores.

Vale ressaltar que, quanto menores a latência e o jitter, mais restrita se torna a janela para recuperação de falhas e reposição de pacotes – exigindo soluções preventivas e tolerância bem definida.

Implicações Práticas em Projetos e Operação de Redes de Vídeo

Projetos que envolvem transmissão de vídeo em tempo real, como videomonitoramento, telemedicina e broadcast corporativo, impõem exigências restritivas a latência, jitter e perda de pacotes. Recomenda-se, para aplicações sensíveis, definição clara dos SLA (Service Level Agreements) considerando:

- Parâmetros máximos de latência ponto a ponto, respeitando finalidade do sistema;

- Índices de jitter compatíveis com tolerância de aplicação embarcada e expectativa do usuário final;

- Taxas de perda máxima por fluxo, prevendo redundância e compensação caso necessário;

- Capacidade de monitoramento, diagnóstico e resposta automática a degradações do serviço, com alertas e registros detalhados para análise forense.

A engenharia de redes deve prever arquiteturas flexíveis e tolerantes, admitindo picos de uso, variações ambientais e crescimento de demanda. Testes de estresse, simulações e medições periódicas compõem o ciclo contínuo de aprimoramento e garantia de qualidade dessas infraestruturas.

Latência, jitter e perda de pacotes são determinantes centrais para a qualidade da transmissão de vídeo em redes de dados, demandando abordagem sistêmica em projetos, operação e manutenção. Definições precisas de parâmetros e planejamento focado em tolerância e mitigação contribuem para reduzir riscos operacionais e elevar o desempenho nas aplicações mais exigentes. O sucesso de soluções de vídeo reside em políticas de qualidade de serviço, dimensionamento de buffers, escolha criteriosa de topologia e monitoramento contínuo. Em ambientes críticos e sensíveis, recomenda-se adoção de práticas proativas, integração de recursos de diagnóstico e constante alinhamento dos indicadores operacionais à expectativa de qualidade esperada pelo negócio e pelo usuário final.